Hadoop建造伪分布式里面的配置文件,需要修改5个配置文件,代码如下,主要是用于方便。

core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master45:9000</value> <!--master45是自己的主机名在hosts里面配置也可以写IP-->

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/download/hadoop3.1/tmp</value> <!--hadoop的安装目录-->

</property>

</configuration>

hadoop-env.sh

export JAVA_HOME=/opt/download/jdk1.8 //Java的jdk目录

hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/download/hadoop3.1/dfs/name</value> <!--hadoop目录的name-->

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/download/hadoop3.1/dfs/data</value> <!--hadoop目录的data-->

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master45</value> <!--主机名-->

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

接下来就是别的配置,如果是2.7的可以不用看了直接初始化全部启动即可,如果是3.2/3.1之类的,就需要再进行修改下面文件

打开 /hadoop/sbin 这个目录,修改(start-dfs.sh、stop-dfs.sh)、(start-yarn.sh、stop-yarn.sh),再到顶部添加下面代码

start-dfs.sh、stop-dfs.sh

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

start-yarn.sh、stop-yarn.sh

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

然后就全部OK,输入下面指令进行初始化然后全部启动

hdfs namenode -format

然后进入sbin文件夹进行全部启动

./start-all.sh

然后jps,出现下面这几项就基本OK了

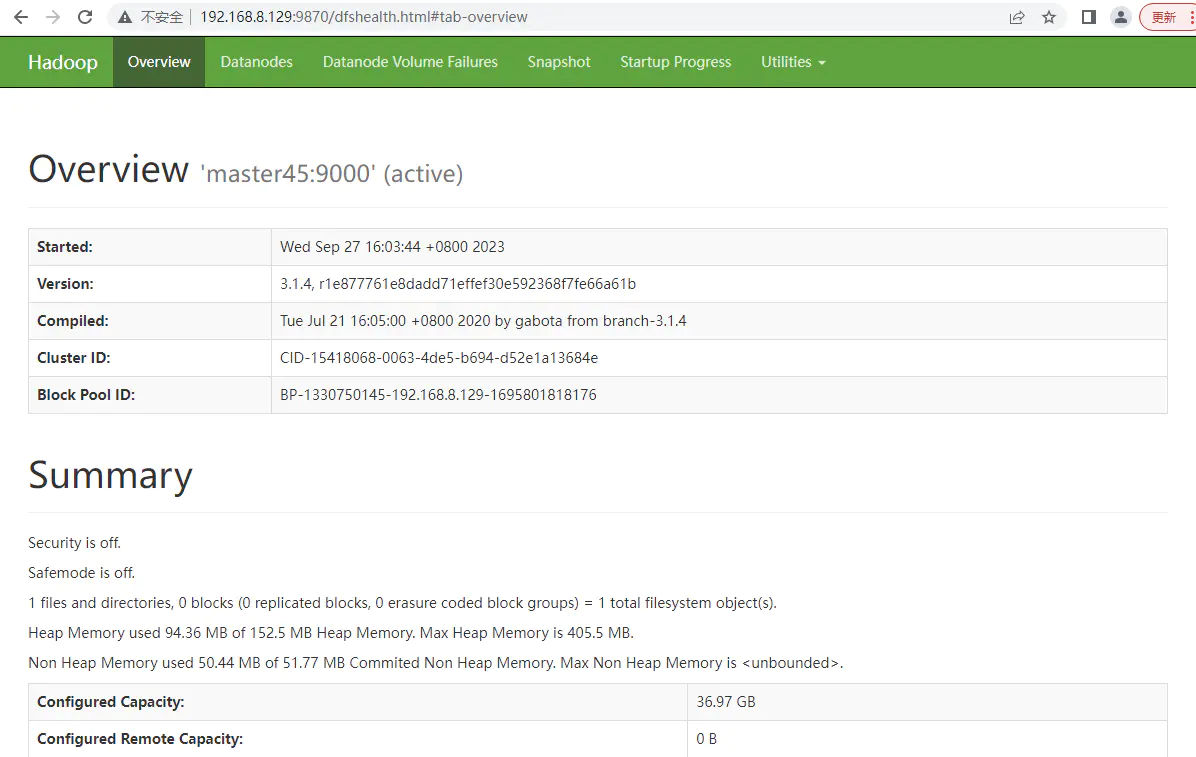

然后输入自己 IP+9870 就可以了

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)